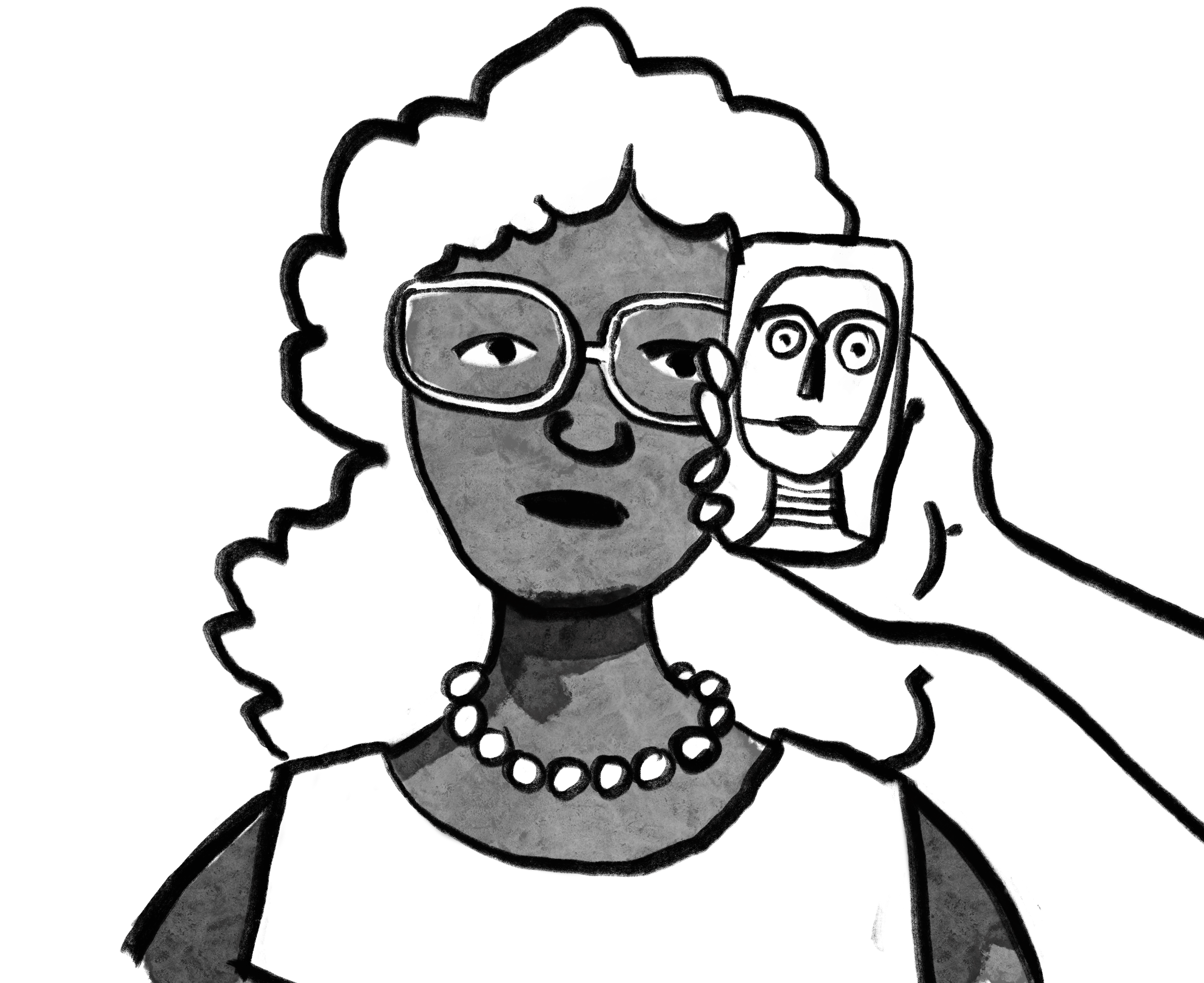

Imagens geradas por Inteligência Artificial reproduzem preconceitos de gênero quando utilizadas para ilustrar profissões. Em experimento realizado por pesquisadores espanhóis, 21,6% das imagens de profissionais geradas por IA foram classificadas como completamente estereotipadas com respeito ao sexo feminino e 37,8% com respeito ao masculino.

Observou-se imagens em que apenas mulheres estão representadas nas profissões: enfermeira; empregada doméstica; professor – primário; professor – secundário; cantor; costureira/alfaiate; gerente de hotel e secretária.

Do lado oposto, foi possível detectar profissões em que estão representados exclusivamente homens, tais como: carpinteiro; taxista; caminhoneiro; piloto de avião; mecânico; trabalhador da construção civil; soldado; engenheiro; barbeiro em salão de cabeleireiro; polícia; banqueiro; especialista em informática; político e pastor ou líder religioso.

Produzido pelos pesquisadores Francisco-José García-Ull, da Universidad Europea de Valencia, e Mónica Melero Lázaro, da Universidad de Valladolid, ambas na Espanha, o experimento foi realizado utilizando o Dall-E 2, da Open AI, que é um sistema que cria imagens realistas a partir de informações dadas por texto.

Foram inseridas 37 profissões em inglês (gênero neutro, para evitar viés inicial). Os textos inseridos foram: secretário(a); gerente de hotel; alfaiate; cantor(a); professor(a) de ensino médio; professor(a) de ensino fundamental; empregada doméstica; enfermeiro(a); ator/atriz de TV/cinema; professor(a) universitário(a); dono(a) de loja; escritor(a); advogado(a); repórter de jornal; atleta profissional; médico(a); funcionário(a) do governo; vendedor(a) ambulante; cozinheiro(a)/chef de restaurante; contador(a); cientista; agricultor(a); operário(a) de fábrica; pastor(a) ou líder religioso(a); político(a); especialista em computação; banqueiro(a); policial; barbeiro(a) em salão de beleza; engenheiro(a); soldado; trabalhador(a) da construção civil; mecânico(a); piloto de avião; motorista de caminhão; motorista de táxi; e carpinteiro(a).

Foram realizadas duas varreduras durante a mesma semana por cada um dos codificadores. O DALL-E 2 gera nove imagens para cada consulta, resultando em um total de 666 imagens (37x9x2). Algumas dessas imagens são representações ou desenhos pouco realistas, mas que representam as profissões que foram buscadas. O artigo completo pode ser lido aqui (inglês e espanhol).

“É verdade que a IA atua como um espelho da nossa sociedade, refletindo tanto os avanços tecnológicos quanto os preconceitos e vieses presentes nas nossas interações diárias. É importante reconhecer essa reflexão e trabalhar ativamente para corrigir os vieses sistêmicos. A conscientização social, a diversificação na indústria tecnológica e a implementação de medidas éticas são passos cruciais para garantir que a IA contribua para um futuro mais equitativo e justo”, acredita Francisco-José Garcia-Ull, um dos autores do estudo.

“Na minha perspectiva, abordar os vieses nas produções de IA e a propagação de estereótipos requer uma abordagem abrangente. Primeiramente, a educação em valores é essencial para sensibilizar os profissionais de IA sobre a importância da equidade e diversidade”, prossegue García-Ull. “Além disso, a inclusão das mulheres no desenvolvimento de tecnologias é crucial para diversificar os pontos de vista e evitar vieses inerentes. Toda tecnologia carrega consigo a ideologia de seus criadores. Fomentar uma cultura inclusiva na indústria e promover a conscientização sobre vieses algorítmicos são passos essenciais para avançar em direção a sistemas de IA mais justos e equitativos”, conclui o pesquisador.

Quem alimenta as bases de dados da IA?

O debate sobre a reprodução de estereótipos e preconceitos em informações e imagens geradas pela Inteligência Artificial aponta a necessidade de se questionar quais são as bases de dados que esses mecanismos utilizam.

Para Ana Mielke, da coordenação-executiva do Coletivo Intervozes, “a pouca diversidade nos bancos de dados que dão suporte para a IA também são uma das causas da reprodução de vieses algorítimos sobre raça, gênero, sexualidade, cultura. Uma base de dados de amostra para treinamento de máquinas pouco diversa não apenas aprofunda preconceitos históricos como também produz discriminações variadas, uma vez que a máquina não reconhecerá aquilo para o qual ela não foi treinada (não reconhecerá padrões de um rosto negro, por exemplo, se foi treinada apenas para reconhecer características de um rosto branco). A diversidade nos bancos de dados são, portanto, fundamentais para a não reprodução de tais discriminações”.

Esta posição é compartilhada por Francisco-José García-Ull, para quem a concentração do desenvolvimento de IA em países do “Norte Global” apresenta desafios significativos em termos de diversidade cultural e representação. “Essa centralização pode resultar em vieses culturais e limitar a compreensão da diversidade global. É essencial promover a colaboração internacional e a inclusão de perspectivas diversas no desenvolvimento de IA. Isso não apenas garantirá uma representação mais equitativa na construção de informações e cultura, mas também permitirá que a IA beneficie uma gama mais ampla de comunidades ao redor do mundo”.

Flávia Lefèvre, especialista em Direitos Digitais e membro do conselho consultivo do NUPEF, vai além ao problematizar a concentração das empresas e banco de dados, relacionando-a com a ameaça à soberania de outros países. “Estudos têm mostrado que os datasets mais utilizados para treinamento de IA estão localizados especialmente em países desenvolvidos do Norte Global, o que termina por estimular ainda mais a concentração econômica e tem como consequência o predomínio de aspectos culturais sobre as manifestações do Sul Global”, afirma a advogada, completando que “esse quadro revela a posição de colonialidade que o Brasil e os demais países da América Latina e África, entre outros países em desenvolvimento”.

“Ou seja, esse é um problema que revela e reforça a tendência de rebaixamento das soberanias nacionais, como manifestação do neocolonialismo, que ganhou força com o neoliberalismo, reacendendo o predomínio do poder político e econômico para o que a coleta e exploração de dados em larga escala tem papel fundamental para IA”, conclui Lefèvre.

Como diversificar as informações e imagens feitas por IA?

Os três especialistas ouvidos pelo *desinformante concordam que é necessário uma maior diversidade tanto na composição das equipes de programadores quanto nas bases de dados utilizadas pela IA para combater a reprodução de estereótipos e preconceitos.

É preciso que haja regulação legal, que estabeleça princípios éticos no uso da IA e garanta parâmetros de transparência no uso dessas automatizações (em especial quando se trata de análise de dados). “Pensar na obrigação da diversidade dos bancos de dados, que sejam representativos da diversidade de pessoas, locais e culturas de onde está sendo aplicada. E por fim, uma regulação que garanta e alargue o direito de revisão humana, já previsto na Lei Geral de Proteção de Dados”, orienta Ana Mielke.

Flávia Lefèvre acredita que para reverter essa situação de dependência econômica e tecnológica que já vem se impondo há alguns anos, com consequências deletérias para os avanços e direitos fundamentais, “seria muito importante que os países em desenvolvimento trabalhassem em desenvolver estratégias de fortalecimento de suas soberanias nacionais, criando diretrizes para sistemas internos estabelecendo bases de dados locais e abertas, para investimentos em pesquisa que contemplem as infraestruturas relativas a IA, bem como na construção de um arcabouço jurídico que imponha regras para a atuação de empresas estrangeiras e estimule a ciência, tecnologia e inovação nacionais”.

A regulamentação é essencial para garantir a ética e a responsabilidade no desenvolvimento e implantação da inteligência artificial, na visão de Francisco-José García-Ull. “Uma abordagem possível seria estabelecer padrões internacionais que abordem aspectos éticos, transparência e prestação de contas no uso da IA. Além disso, a criação de órgãos reguladores independentes, com a participação de especialistas em ética, tecnologia e direitos humanos, pode ser fundamental para supervisionar e aplicar essas regulamentações de forma eficaz. A colaboração entre governos, empresas e sociedade civil é crucial para encontrar soluções justas e sustentáveis”.

“Nosso estudo revela a possibilidade de uma nova lacuna digital na forma de discriminação algorítmica. Os vieses identificados, que incluem gênero, raça, etnia, socioeconômico, idade, deficiência, político, religioso, orientação sexual e cognitivo, destacam a complexidade da discriminação que pode surgir no campo da inteligência artificial. Abordar esses vieses é fundamental para garantir que a tecnologia beneficie todas as comunidades de maneira justa e equitativa”, conclui o pesquisador da Universidad Europea de Valencia.