Este artigo contou com a colaboração de André Lucas Fernandes e Tarcizio Silva

O texto preliminar substitutivo (TPS) ao Projeto de Lei 2338/23, que busca regular a inteligência artificial (IA) no Brasil, trouxe uma série de retrocessos que pegaram os especialistas de surpresa. Uma das mais críticas inovações negativas é a permissão, no art. 13, do uso de Sistemas de Armas Autônomas (SAA) em determinados contextos no território nacional, uma vez que o TPS excepciona sua aplicação para a defesa nacional. Esta disposição, apesar de inicialmente trazer a vedação destes sistemas, limita esta proibição apenas nos casos em que não há controle humano significativo e quando os efeitos forem “imprevisíveis ou discriminados” ou quando o uso implicar em violações do Direito Internacional Humanitário, o que abre muitas brechas para a violação de direitos.

De acordo com o Comitê Internacional da Cruz Vermelha (CICV), SAA é um termo genérico que abrange qualquer tipo de sistema de armas com autonomia em suas funções críticas, a partir de uma combinação entre sensores, algoritmos e software, que podem aprender ou adaptar seu funcionamento em resposta à mudanças nas circunstâncias. Uma vez desenvolvidas e lançadas, teriam a capacidade de selecionar, encontrar e atacar alvos sem intervenção humana significativa ao fazer a equivalência entre o que os sensores detectam no ambiente e determinado “perfil alvo” (objeto ou pessoa).

Simplificando: são sistemas automatizados com poder de decisão para ferir ou matar assim que acionados, ou, em último grau, com acionamento automático a partir de uma programação pré-definida. De acordo com Mariarosaria Taddeo e Alexander Blanchard, após analisar definições de vários órgãos internacionais, os SSA seriam sistemas capazes de modificar o seu status interno de julgamento para atingir objetivos pré-definidos, tendo a capacidade de mudar suas próprias regras, de forma transitória, para atingir uma entidade física (objeto ou ser humano) de forma autônoma.

Conforme relatório desenvolvido pela Human Rights Watch (HRW) e pela International Human Rights Clinic (IHRC), as armas autônomas não seriam capazes de adequar-se aos princípios de DIH, por carecerem de características humanas que são consideradas essenciais para seu cumprimento, uma vez que sua aplicação pode ser complexa, subjetiva e variável de acordo com o caso e as circunstâncias do momento, especialmente em conflitos dinâmicos.

Desta forma, armas autônomas não seriam aptas a determinar alvos legítimos em um contexto em que os combatentes não são identificáveis apenas por marcações físicas e de maquinário, sendo necessária a interpretação do comportamento humano e suas intenções, o que é particularmente difícil de ser inserido dentro de um código de programação, podendo, inclusive, ocasionar a morte acidental da população civil em razão da má interpretação de dados.

Gregoire Chamayou, autor do livro “Teoria do Drone”, analisou o cenário de SAA em usos de guerra e levantou questões que denunciam um cenário de incerteza e insegurança. Afinal, na guerra ou na ordem civil, quem seria responsável por uma ação errada de um robô do tipo: o agente que ordenou, o Estado proprietário, o industrial produtor da tecnologia, ou os programadores?

Além das problemáticas éticas, jurídicas e humanitárias, também estão presentes problemas relativos aos interesses e estratégias geopolíticas de Estados e de entidades (privadas) transnacionais. Por exemplo, o montante movimentado por empresas fabricantes de armas autônomas é alimentado em grande medida por um ciclo vicioso entre tecnologias de ocupação e tecnologias fronteiriças entre União Europeia e Israel.

O jornalista judeu Antony Loewenstein intitulou seu último livro como “The Palestine Laboratory” (O Laboratório Palestino) para descrever como a violência contra palestinos pelo estado israelense é usada como case de sucesso por empresas do país, como Elbit, High Lander e Seraphim Optronics, que vendem armas e softwares para todo o mundo.

A recente aprovação do AI Act na União Europeia foi criticada por analistas de organizações, como a AccessNow, que avaliaram que o texto final falhou na proteção dos direitos humanos, reforçando o poder do setor privado e violência estatal. O argumento é que as exceções incluídas no texto não só permitirão aumento do uso de armas autônomas nas áreas fronteiriças, como incentivarão o uso contra cidadãos do grupo, internamente.

Assim, fica claro que os riscos e potenciais danos de SAA não se configuram apenas em cenários apocalípticos de ficção científica com robôs assassinos humanoides totalmente à solta. Cenários de violações de direitos já existem com a combinação de tecnologias de vigilância, policiamento preditivo e armas letais autônomas e semiautônomas, muitas das vezes em atuação conjunta. A automatização do massacre e destruição em massa na Faixa de Gaza pelo exército israelita torna isso claro.

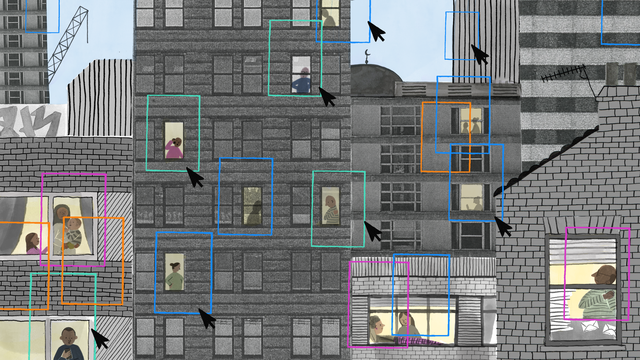

Além da sua clara utilização em contexto de guerra, é possível que seu uso seja adaptado para atuações internas de Estados para cumprimento da lei, o que exigiria o cumprimento do Direito Internacional dos Direitos Humanos, aplicável tanto em situações de guerra como de paz para regulação do uso da força. SAA – ou conceito popular, “robôs assassinos” – poderiam ser utilizados internamente por polícias locais para, por exemplo, combate ao crime, gerenciamento de protestos públicos, controle de tumultos, repressão ao terrorismo e muitas outras hipóteses de manutenção da ordem e segurança pública, o que é uma clara ameaça para direitos humanos fundamentais, como vida, dignidade e não discriminação.

No contexto brasileiro, a dimensão internacional se torna secundária pelo clima de adoção e incorporação de tecnologias usadas em conflitos bélicos em cenários de “guerra interna”. Coloca-se o aparato letal contra o próprio cidadão, num exercício de internalização de uma necropolítica, em que a violência policial contra negros se torna política de Estado. A predominância do policiamento militar ostensivo no Brasil põe em cheque compromissos democráticos sobre o uso da força pelo Estado.

Levantamentos demonstram que o país lidera, de longe, a letalidade policial entre as maiores economias do mundo. Mesmo na América Latina o hiato é assombroso. No Brasil, o índice de letalidade policial é de 2,7 por mil habitantes, comparado a 0,5 na também complexa e desigual Colômbia, segundo o estudo “Monitor of Use of Lethal Force in Latin America and the Caribbean” de 2024. A violência e letalidade policial no Brasil são reflexos dos problemas estruturais das forças de segurança e da própria sociedade, permeada por racismo, o que é confirmado pelos números do Anuário Brasileiro de Segurança Pública que, em 2023, apontou que 83,1% das vítimas de intervenções policiais eram negros.

Em episódios recentes, representantes eleitos defenderam o uso de drones para disparos em ações policiais de segurança no Rio de Janeiro, inclusive com viagem para Israel para estudar possibilidade de compra destas tecnologias, que poderiam também dispor de reconhecimento facial.

Esse cenário é ainda mais grave diante do já constatado racismo algoritmico de sistemas de IA, que reforçam e atualizam o racismo estrutural da sociedade brasileira. Nesse cenário, considerando os muitos potenciais impactos do uso de SAA nos direitos humanos, sua reprovabilidade é latente tanto nos casos em que funcionam mal como nos de bom funcionamento, quando atingem justamente a população que já é rotineiramente alvo.

Assim, apesar do artigo 13 do TPS brasileiro tentar limitar o uso de SAA para situações de controle humano significativo, esta limitação acaba por não surtir efeitos práticos. Tecnicamente, argumenta-se que tais aparatos podem ser programados para uma intervenção humana mais eficiente (human in the loop), mas o uso desse arsenal em ambientes não controlados, como em guerra, têm comprovado o aumento dos casos de erros e efeitos negativos que atingem todo o entorno dos locais em que estas armas atuam. O elemento humano se torna completamente precário, se pensarmos no contexto brasileiro de desabastecimento, falta de treinamento e fortalecimento do controle Estatal sobre as polícias.

A Organização das Nações Unidas (ONU) discute o desenvolvimento e o uso de sistemas de armas autônomas no âmbito das reuniões dos Estados signatários da Convenção sobre Certas Armas Convencionais (CCAC). Nesse cenário, os membros ressaltam a importância da manutenção do controle humano sobre o uso da força, o que é seguido por outros organismos internacionais e organizações não governamentais, a exemplo do CICV e da campanha “Stop Killer Robots”, coligação global de centenas de organizações, que defende a proibição e a regulamentação de SAA.

Diante do potencial danoso dos SAA, em razão das dúvidas quanto a possibilidade de cumprimento das regras de DIH e de Direitos Humanos, os pedidos de sua proibição prévia se multiplicam, incluindo o Secretário-Geral das Nações Unidas, António Guterres.

No final de 2023, 152 estados votaram na Assembleia Geral da ONU a favor da primeira resolução sobre os perigos das armas autônomas, o que foi reafirmado em abril de 2024 em nova resolução firmada na 148ª Assembleia Geral da União Interparlamentar em Genebra. Atualmente, o apelo à negociação de um instrumento juridicamente vinculante sobre armas autônomas é apoiado por mais de 100 estados, especialistas em tecnologia, líderes religiosos (como a Santa Sé e Papa Francisco) e organizações da sociedade civil mundialmente.

Somada à reprovabilidade internacional, em campanhas mencionadas, o contexto real brasileiro mostra cabalmente que a autorização de uso de SAA pelo TPS, encampada e apoiada pelo Governo Federal, poderá por o Brasil na contramão dos debates de direitos humanos, em verdadeira afronta a tratados e compromissos já firmados pelo país, como a CCAC, a liderança brasileira no âmbito das discussões do Grupo de Peritos Governamentais da ONU sobre o tema e a resolução mencionada sobre os perigos das armas autônomas de dezembro de 2023.

Por fim, parece essencial considerar o desenho de redes de incentivos que decorrem de perspectivas armamentistas. No passado recente, o Brasil tem sofrido com a influência política de atores interessados em fortalecer mercados de produção e venda de tecnologias da violência, como armas de fogo e câmeras de reconhecimento facial – influenciando o Estado a priorizar sua compra frente à investimentos em saúde pública. A reprovação dos SAA no futuro marco legal de IA mitiga incentivos perversos à produção artificial de demanda dessas tecnologias.

Não parece razoável, por estratégia política, autorizar o uso de tecnologias falhas em detrimento de vidas, muitas das quais, negras e periféricas. Para além dos claros usos ilegítimos de tecnologias de vigilância atualmente no país, olhando para reprováveis exemplos como a atual ofensiva de Israel, não há uma maneira ética ou mecanismos de prevenção e mitigação suficientes para justificar o uso desses sistemas.